Danke dafür.

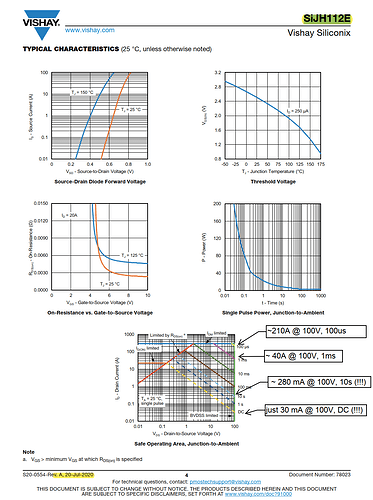

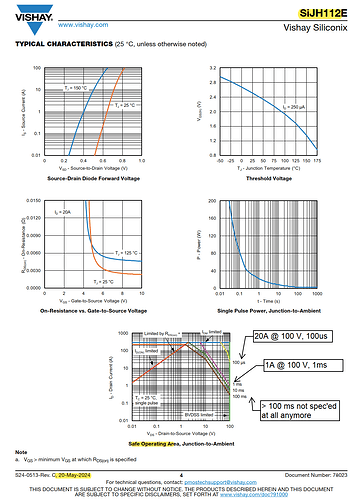

Das Problem dürfte im Moment eher die Eload sein. Die besteht ja auch aus FETs mit SOA. Die 300A schaffe ich im Moment nur für maximal 1 ms.

NH-Sicherungen von ETI habe ich sogar hier. Der Halter mit Lasttrenngriff zu einem solch attraktiven Kurs ist aber ein guter Tipp.

Für mich ist im DIY ESS Bereich NH bei großen 48 V Batterien, als "last line of defense" eigentlich gesetzt. Ich kenne nichts, was ein besseres Preis-Leistungsverhältnis bieten würde.

Da ich normalerweise eher Leistungselektronik mit Flanken im 10 ns Bereich entwickle, habe ich in der Tat Zugriff auf Stromzangen mit BW bis > 100 MHz.

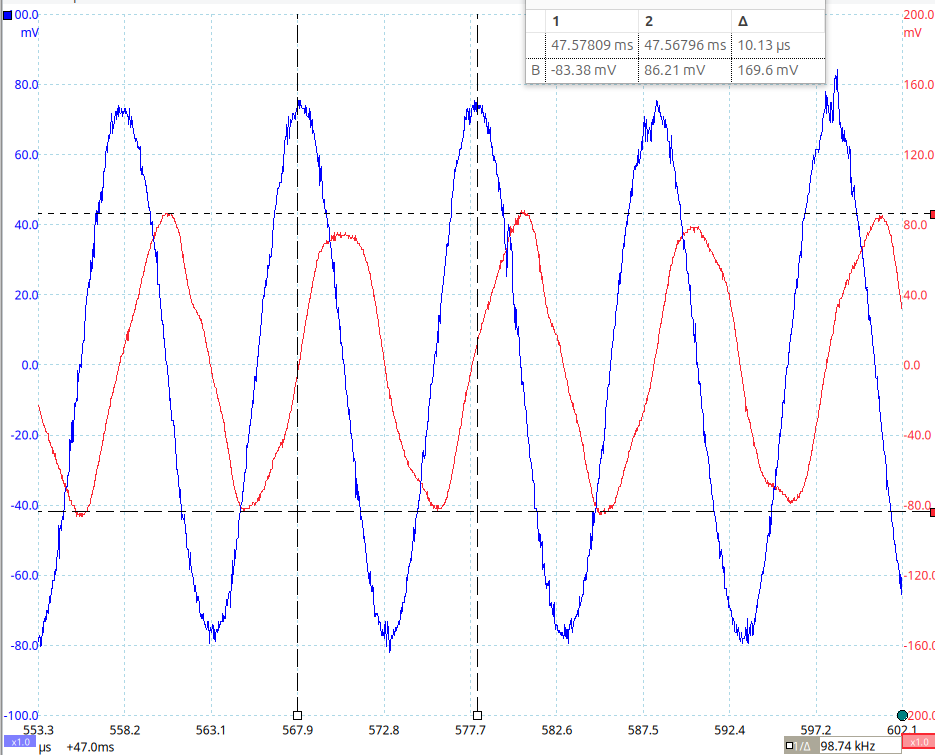

Das der Phasenwinkel zwischen Strom und Spannung nicht ideal 90° sein würde, ist natürlich klar. Ich habe aber im Vorfeld abgeschätzt, dass das keine relevante Auswirkung auf die Validierung meiner Abschätzung zu der Batterieinduktivität haben würde.

Im Zeitbereich sieht man auch auf den ersten Blick, dass das grob hinkommt:

( blau ist der Strom in 100 mV/A, rot die Spannung )

Die Spannung ist kein sauberer Sinus, weil der Verstärker deutliche harmonische und auch nicht-harmonische Störer produziert. In der Stromkurve sind die schon teilweise rausgefiltert.

Die eigentliche Auswertung erfolgt dann aber im Frequenzbereich.

Du denkst hier "zu sehr" im Zeitbereich.

Unter der Annahme, dass sich das System weitestgehend linear verhält, ist es aber in der Regel effizienter die Auswertung rein im Frequenzbereich zu machen. Dann hat man bei der Grundfrequenz nur noch zwei Amplituden( und eine Phasenverschiebung) und gut. Jedes anständige LCR-Meter dürfte auch so arbeiten.

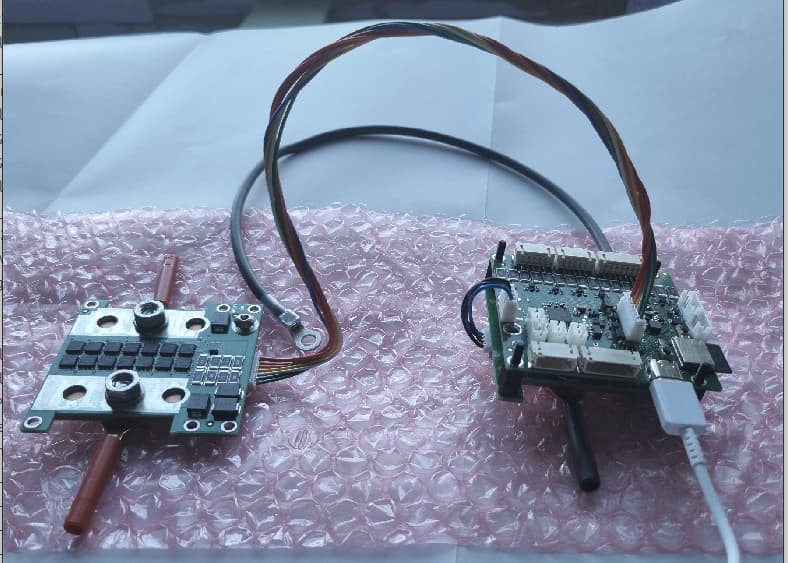

Es ist in jedem Fall bequemer/effizienter. Ich kann so Parameter wie ESR, ESL der Batterie mit kleinem Aufwand praktisch nach Belieben anpassen. Außerdem ist die zur Verfügung stehende Energie, wenn etwas schief läuft deutlich geringer und alle Umbauten erfolgen komplett spannungslos.

Abschließend werde ich aber definitv auch noch an einem echten Pack testen.

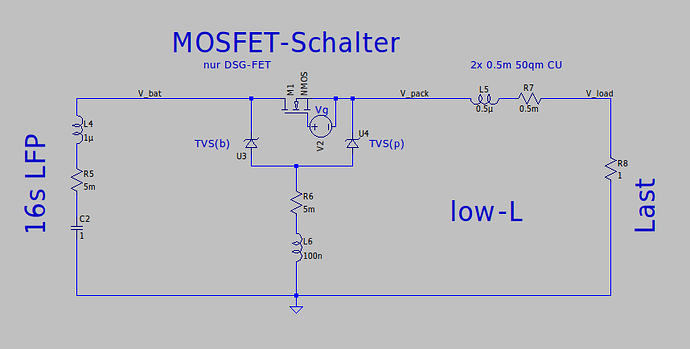

Das wird aber erst mit der neuen HW-Revision des MOSFET-Schalters erfolgen.

Da geht es dann letzlich vorwiegend darum zu verifizieren, wie nah die Realität an dem ist, was ich in der Schaltungssimulation dazu heute bereits sehe.

Außerdem werde ich versuchen den Strombereich, den ich wohldefiniert mit der Eload testen kann, in den Bereich > 1000A hochzusetzen, da es meines Erachtens zur Qualitätskontrolle unerlässlich ist, dass ich eine große Anzahl von Abschaltevents mit kleinem Aufwand in kurzer Zeit durchführen kann.

Der Punkt ist, dass ich den SOA-Angaben in Datenblättern eigentlich grundsätzlich nicht traue. Eine experimentelle Überprüfung mit statistischer Relevanz ( also nicht nur 10 Tests an einer HW ) ist in meinen Augen essentiell.

Da die "thermal instability", die zu den überproportional abnehmenden erlaubten Stromstärken bei zunehmender Pulsdauer führt, im Umkehrschluss aber bedeutet, dass bei kürzeren Pulsen die FETs "robuster" werden, ist glücklicherweise klar, dass man im worst-case schlicht schneller schalten muss. Dadurch dann aber mehr Aufwand mit dem kontrollierten Abbau der induktiven Energie hat.

Das Hässliche ist auch, dass sich jeder FET Type von jedem Hersteller deutlich unterschiedlich verhalten kann, man eine solche Validierung also für jeden Ersatztyp neu durchführen muss.

Das ist bei einem BMS also definitiv ein Dauerthema.