Wenn man volle 4-fache Redundanz haben möchte, ist dies natürlich grundsätzlich möglich.

In der Vorstellung hatte ich beschrieben, dass ich einen 500 uOhm 14p MOSFET-Schalter, wenn er ohne Kühlkörper rein passiv gekühlt und direkt an den Zellen montiert ist, nur bis etwas 100 A also ~ 5 W Verlustleistung nutzen würde.

Bei Deinen Anforderungen würde ich für eine kosteneffiziente Lösung aber anders vorgehen:

Bei einem JK BMS entspricht ein 15p/20p MOSFET-Schalter einem 150 A/ 200 A BMS.

Nicht direkt auf den Zellen montiert und mit einem Kühlkörper versehen wäre das auch für meine HW eine realistische Auslegung.

Dann bleibt noch die Frage, welche MOSFETs man verwendet. Ich habe im Moment Prototypen mit FETs von "westlichen" Herstellern ( wie Toshiba, Infineon ) und chinesischen ( wie Huayi, die typischerweise auch auf einem China-BMS verbaut sind )

Der Preiunterschied liegt bei einem Faktor von 2-3.

Im Moment habe ich keinen konkreten Anlass zu der Annahme, dass man mit den chinesischen FETs keine vergleichbar robuste Lösung hinbekommt. Einige Test stehen aber noch aus.

Da mir völlig klar ist, dass die Preismarke, die chinesische Firmen wie JK gesetzt haben, immer als Referenz im Raum stehen wird, und ich von vornherein darauf hingewiesen habe, dass Kosteneffizienz bei der Auslegung meines BMS ein wichtiges Kriterium war,

möchte ich eine grobe unverbindliche Abschätzung aufzeigen, wie das bei meinem BMS mal aussehen könnte.

Dabei bitte ich aber zu berücksichtigen, dass es mir hier vorwiegend darum geht, konkret plausibel darzustellen, dass mein BMS keine Spielerei aus dem Elfenbeinturm ist, sondern im aktuellen Markt wettbewerbfähig wäre.

Ob es dazu mal kommen wird, ist gegenwärtig völlig unklar.

Folgenden Annahmen liegen dem zu Grunde:

- Fertigung in Losgrößen von eher > 1000 Stück

- Ein schlanker Direktvertrieb durch eine Firma in der EU mit allen Regularien ( WEEE, Verpackung... ), die für jemanden, der in der EU sitzt, nicht so einfach "dehnbar" sind wie für einen Verkäufer auf Ali.

Shunt-Platine: ~ 15 €

Steuer-Platine: ~ 45 €

MOSFET-Schalter-Platine_10p: ~ 35 € ( China FETs, ~ 700 uOhm <=> ~ 75 A "nackt", ~ 100 A mit Kühlkörper )

MOSFET-Schalter-Platine_14p: ~ 50 € ( China FETs, ~ 500 uOhm <=> ~ 100 A "nackt", ~ 140 A mit Kühlkörper )

MOSFET-Schalter-Platine_20p: ~ 70 € ( China FETs, ~ 380 uOhm <=> ~ 130 A "nackt", ~ 200 A mit Kühlkörper )

Im Grunde in Anlehnung an das, was hier im Forum oft als "nordkyn-Studie" bezeichnet wird.

Wenn die Zellen im Spannungsbereich von 3.4 - 3.65 V liegen und ein von der Spannung anhängiger Ladestrom unterschritten wird, wird auf 100% zurückgesetzt.

Das gewährleistet, dass weitestgehend unabhängig von der gewählten Ladeschlussspannung und Stromkurve gegen Ladeende der SOC100-Reset bei einer definierten Sättigung der Anode auftritt.

Grundsätzlich kann der Spannnungsbereich und die Stromrampe voll konfiguriert werden. Da das aber etwas ist, was durch die Elektrochemie von LFP vorgegeben ist, gab es da bei mir bis jetzt keine Notwendigkeit für.

Was in diesem Modell nicht berücksichtigt ist, ist ein ausgeprägter "Memory-Effekt".

Wenn also viele Zellen in einem Pack einen starken "Memory-Effekt" hätten, dann würde die Logik von oben inkonsistente Ergebnisse liefern.

Unter meinen 96 Zellen habe ich nur zwei Zellen ( in einem Pack ), die einen starken "Memory-Effekt" zeigen. Damit hat die Logik von oben keine Probleme.

Trotzdem habe ich inzwischen eine Detektion von "Memory-Effekt"-Verhalten eingebaut, so dass man darauf zukünftig reagieren könnte.

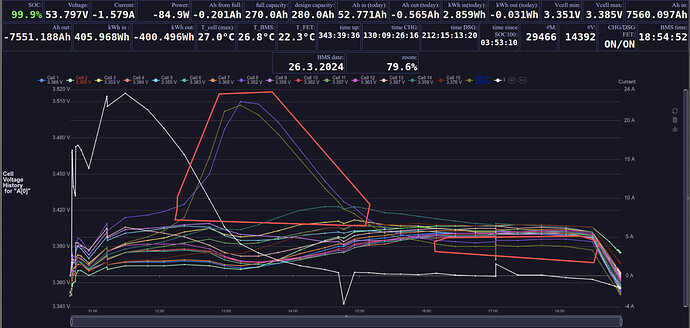

Wenn das so ähnlich aussieht wie hier ( hast Du Screenshot zu dem Verhalten bei Deinem Kumpel ?)

dann klingt das nach dem, was ich oben als "Memory-Effekt" bezeichnet habe.

Bei einer oder zwei Zellen im Pack hat mein BMS da überhaupt kein Problem mit, solange die Zielladespannung entweder manuell sinnvoll gewählt ist, oder das BMS den WR steuern kann.

( dem Screenshot kann man sogar entnehmen, das der SOC-Reset gegen 15:00 Uhr erfolgt ist )

Ohne die Detektion das eine Zelle dieses Verhalten zeigt, kommt es natürlich dazu, dass während des Peaks der Balancer der Zelle fälschlicherweise Ladung entnimmt, die dann später zur Korrektur auch allen anderen Zellen entnommen werden muss.

Deswegen habe ich die Detektion eingebaut, so dass das Balancing für solche Zellen in der "Peak-Phase" gesperrt werden kann.

Woran mein BMS natürlich nichts ändern kann, dass die Endphase des Volladens bei solchen Zellen viel länger dauert, da unter Umständen mehrerer Ah Ladung nur noch mit Strömen von 1 A geladen werden können.

Das habe ich sehr ähnlich umgesetzt.

Einmal wird der dem WR erlaubte (Ent-)Ladestrom bei hoher/niedriger Zellspannung, bei hohen/niedrigen Zelltemperaturen und bei niedrigem/hohem SOC reduziert.

Wenn trotzdem eine Zelle wegläuft, wird die erlaubte Ladespannung reduziert.

Um durch Regelung eines WR, bei dem im Zweifelsfall nur die Ladespannung vorgegeben werden kann, einen Pack in einem definierten SOC-Bereich halten zu können, kann ich so gar noch einen Schritt weitergehen und die Ladespannung des WR kontinuierlich regeln.

Das Beispiel zeigt das Vollladen durch einen Victron RS solar 48/6000, der durch das BMS gesteuert wird.

Die Zielladespannung ( CVL ) wird hier zwar nicht direkt angezeigt, an den "Zacken" im ~ 30s Raster im Ladestrom kann man aber ableiten was passiert:

Durch dass Vollerwerden der Zellen sinkt der Ladestrom bei gegebenem CVL solange, bis das BMS zum Erreichen des Zielladestroms wieder 0.1 V zusätzlich für CVL freigibt.

Sobald der WR darauf reagiert springt der Ladestrom um ein paar Ampere, um dann wieder langsam zu fallen.

Da man über das Pylontech Protokoll CVL nur in 0.1 V Schritten vorgeben kann, sind diese kleinen Sprünge dann aber leider unvermeidbar.

( Der kurze Einbruch kurz nach 17:20 ist übrignens der Global Scan vom Victron. )