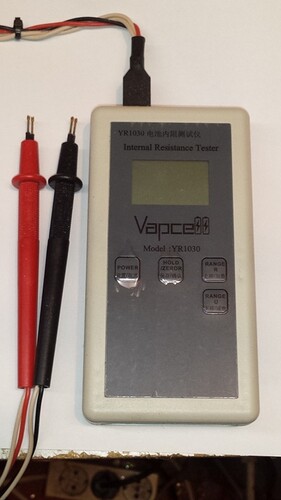

Ich verwende das gleiche wie Andreas: Vapcell YR1030 und bin sehr zufrieden! Die Reproduzierbarkeit ist sehr genau (kaum Abweichung). Klare Kaufempfehlung von mir.

Das gibt es jetzt offenbar mit neuem Gehäuse. Ob sich sonst noch etwas geändert hat, kann ich dir nicht sagen. Einfach mal googeln nach Vapcell YR1030. Ich habe es bei einer deutschen Firma bestellt. Vieleicht können die Auskunft geben, ob sich etwas verändert hat. Das könntest du dann auch gerne hier posten :mrgreen:

Gibts aber auch günstiger aus China.

BG, Elton

Dann werde ich mir mal so ein Teil kaufen.

So eine "all in one" Lösung wäre ja genau mein Ding.

Der Traum wäre ein Gerät für 30 Zellen auf z.B. Arduino Basis das den Innenwiederstand misst dann den Akku lädt und entlädt für die Kapazitätsmessung. Letztlich wieder auf eine definierbare Lagerspannung entlädt und mir für die Zelle einen Aufkleber mit Barcode und den ermittelten Werten druckt und das ganze in einer Datenbank ablegt.

Teilweise sind solche Lösungen ja auf dem Markt aber in einem Guß gibt es da nichts richtiges wie ich finde.

Andreas,

Wie ist der Stand deines Tools? Da ich in der sammelphase bin, kann ich dich demnächst mit Daten „zuschmeissen“... und das Tool ist bestimmt hilfreich in meinem Stadium. Anfangs-V und -IR der geernteten Zellen habe ich notiert. Brauchst du dann dazu die gemessene Kapazität?

VG

Eddy

Hi Andreas,

da ich nun auch schon einige Zellen getestet habe möchte ich meine Daten, falls überhaupt noch benötigt, zur Verfügung stellen.

Bei Fragen einfach melden.

Gruß Marcel

4194=1167-Powerwall-inkl-repackr.zip|attachment (636 KB)

Also der Stand des Tools ist:

Fertig ![]()

Naja zumindest für meine Zwecke funktioniert das recht gut, ich kann in ca. 3-5 Tagen eine Zelle vollständig testen und dann einsetzen.

Der Testprozess selbst dauert nur ein paar Sekunden.

Da ich jetzt wieder etwas mehr Zeit habe, können wir gerne eine "Teilveröffentlichung" angehen.

Ich würde demnächst einen Aufruf starten und einen Beta/Alpha Tester suchen und dann sehen wir weiter.

Also der Stand des Tools ist:Mal ein wenig Off Topic, schön zu hören das Du wieder Zeit hast, und ???? Kann man Gratulieren ??

Fertig :D

Naja zumindest für meine Zwecke funktioniert das recht gut, ich kann in ca. 3-5 Tagen eine Zelle vollständig testen und dann einsetzen.

Der Testprozess selbst dauert nur ein paar Sekunden.

Da ich jetzt wieder etwas mehr Zeit habe, können wir gerne eine "Teilveröffentlichung" angehen.

Ich würde demnächst einen Aufruf starten und einen Beta/Alpha Tester suchen und dann sehen wir weiter.

MFG Uwe

Na klar, alles gut gelaufen. Ofiziell darf ich mich aber erst Doktor schimpfen, wenn die Urkunde da ist ![]()

Na klar, alles gut gelaufen. Ofiziell darf ich mich aber erst Doktor schimpfen, wenn die Urkunde da ist :DSuper, Herzlichen Glückwunsch Heimlicher Doctor, super, freue mich für Dich TOP !

MFG Uwe

Na dann, herzlichen Glückwunsch und viel Erfolg weiterhin.

Gruß Manfred

Auch von mir herzlichen Glückwunsch ![]()

Würde mich als Tester anbieten.

Schönes Wochenende euch allen

Eddy

Herzlichen Glückwunsch Dr. Backe ![]()

Auch von mir, Herzlichen Glückwunsch!

Danke ![]()

Das ist ja lustig zu lesen hier, und auch noch in einem deutschsprachigem forum.

machine learning mit gebrauchten zellen.

Aber super das ihr vielschichtig denkt, fördert die kreativität und die "ablibity to solve problems".

Andreas, ich hab auch deine Diss durchgeschmökert, ML findet seinen Weg überall hin, auch im Maschinenbau, sehr cool.

Die Ansätze und das Vokabular sind oft anders obwohl das gleiche gemeint ist.

Ich selbst mach ML seit über 15 Jahren und verdiene auch mein täglich Geld damit darum muss ich hier mal meinen Senf abgeben ![]()

Hab auch schon einige competitions gewonnen, hier mein kaggle profile: https://www.kaggle.com/mjahrer

Das ürsprüngliche Problem waren 3 features (nom capacity, voltage, internal resistance) und target ist gemessene capacity.

Also eigentlich regression.

Bei so einem kleinen feature space kann man schon fast von Statistik Ansätzen sprechen, aber ML passt immer für ein lernbares problem.

Man könnte noch weitere features wie "zustand", "hersteller", "von wo ausgebaut" mit nehmen, nur so an Anregung.

Das model "Co-Kriging" hab ich noch nie gehört, funktioniert aber sicher ganz ok wenn ich mir deine ersten results anschaue.

Ich würde für so ein problem "lightgbm" nehmen. Das ist der standard learner für tabular datasets den man auf jeden Fall als "ML guy" in seiner werkzeugkiste haben soll. lightgbm ist state-of-the art im bezug auf die genauigkeit und speed. Vergleichbar mit xgboost.

Wichtig ist der Ansatz.

Für regression kann man zB. L1 loss nehmen und ein 5-fold cross-validation setting optimieren lassen.

Dann hast ein prediction model das einen wert "die kapazität" vorhersagen kann. Jedoch keine confidence invervalls oder sonst irgendwelche maße der schwankungsbreite.

Man kann den gesamtfehler am cross-validation set anschauen.

cross-validation ist eine methode um die generalisierbarkeit des modells zu beurteilen. prediction on unseen data.

Anderer Ansatz wäre zB einen multiclass classifier wieder mit lightgbm zu trainieren, auch mit 5-fold cross validation.

Targets wären kapazitätsklassen: 0-1500,1500-2000,2000-2500,2500-3000,3000-inf. 5-class problem.

Dann bekäme man eine wahrscheinlichkeitsverteilung über die 5 klassen als prediction. Summieren sich zu 1.

Oder man könnte mehrere binäre classifier auch mit lightgbm trainieren.

Targets wären <1500, <2000, <2500, <3000, >=3000 zB.

Predictions wären kalibrierte wahrscheinlichkeiten für die jeweiligen klassen. Summieren sich jedoch nicht zu 1.

Michael

Moin Michael,

cool dass ein ml Mensch hier am Bord ist und deine Ansätze klingen sehr spannend.

Wir entwickeln momentan ganz fleißig an der prediction und als Model wird es auf jeden Fall ein co kriging werden, das dürfte hier kaum zu schlagen sein.

Der große Vorteil ist einfach, dass das ein statistisches Modell ist und für die Fragestellung extrem gut passt (Varianz Vorhersage). Kriging ist im Prinzip ein unbiased gausscher Prozess und co Kriging kann dann verschiedene Datensätze verarbeiten und statistisch in Verbindung setzen. Neuronale Netzwerke oder trees sind hier einfach nicht die richtigen Modelle.

Ich wollte aber auch für jeden Zelltyp ein eigenes Modell aufsetzen und "ähnliche" Zellen mit als Unterstützung nehmen.

Auch die Bestimmung von Kennwerten der einzelnen Zellen ist total interessant und hilft schon bei der prediction.

Wir denken einfach anders beim Ansatz.

Du hast sicher im Hinterkopf ein "einfaches" erklärbares model das gleich die unsicherheit mit ausspuckt und sonst noch alle gutmütigen Eigenschaften hat.

Was auch total wichtig ist hier um zu wissen was ab geht.

Meine ML models sind alle auf Genauigkeit getuned, da kommst an trees und neural nets nicht vorbei.

Was anderes wird praktisch nicht mehr eingesetzt.

Die intelligenz liegt in den features oder im feature design und am Errormaß und am Ansatz.

Genauigkeit immer auf "unseen" data / test set. Und parameters local auf cross validation tuned.

Wennst nur mAh als regression target hast würde sich MAE oder RMSE eignen.

In meinen anfängen vor 15 Jahren auf der Uni haben wir auch gaussian mixture models analysiert theoretisch wie praktisch trainiert.

Was beteutet Varianz? kann man die messen? objektiv beurteilen mit einem fehermaß über eine menge an samples? oder ist das nur eine model Eigenschaft.

Wenn du pro sample/zelle eine varianz mit angeben kannst dann kannst wieder ein tree model trainieren die das lernt.

Nein ich habe nur im Kopf, dass das Modell extrem gut zu der Problemstellung passt und bin nicht auf nur eine Art von Modell festgefahren. Also ich nehme aus dem riesen Topf von ML-Modellen das bestmögliche für das jeweilige Problem. Ich arbeite selbst im KI/ML Bereich und entwickle extrem große Neuronale Netzwerke, das sind auch komplette Neuentwicklungen die ich dieses Jahr noch veröffentlichen wollte. Das ist, wie bei dir auch, mein Job. Aber ich nehme Neuronale Netzwerke selten für Regressionsprobleme aus dem Messtechnik Bereich, die sind da einfach Fehl am Platz. Im besten Fall bayesisch trainierte NNs, das kann durchaus Sinn machen, aber selbst da sind mir die Nachteile oft zu groß.

Varianz ist ein statistisches Maß für die Unsicherheit/Streuung von Daten. In diesem Fall hat man zum einen eine Modellvarianz (Unsicherheit des Modells selbst) und zum anderen die Varianz in den Daten selbst durch die Messungunsicherheit. Zudem 2 Datensätze für jedes Modell die stark korreliert sind, also einmal den Datensatz für den Akku selbst und einen Datensatz mit ähnlichen Daten.

Daher passt das Co-Kriging hier absolut perfekt. Die Daten scheinen zudem auch mehr oder weniger normalverteilt und dann ist das Kriging auch vom mathematischen Ansatz sogar der bestmögliche Schätzer.

Aber das Regressionsproblem ist auch ziemlich primitiv und letztlich gar nicht so extrem wichtig. Viel wichtiger ist die Datenvorverarbeitung und plausibilitätschecks usw. Auch das Interface für die user wird noch interessant.

Aber schön mit jemanden darüber zu diskutieren ![]()

Hab mir mal die wiki page über Kriging überflogen.

Das ist eine methode zur interpolation - was meinen lauen verdacht bestätigt.

Da das problem hier hat einen 3-dim. feature space hat passt das.

Kannst sicher gut die point cloud der "samples" mit einem 3d scatter plot visualisieren. Oder in mehreren 2d scatter.

ML wie ich es praktiziere arbeitet immer auch hochdimensionalen feature spaces - da ist die dichte so dünn - da geht nix mit klassischer "interpolation".

Obwohl ML models ja genau das machen - das nennt man dann generalization. Gemessen wird die qualität mit einem errormaß auf unseen data.

Es gibt immer was zum lernen auch für mich.

Hab vor Jahren mit splines daten interpoliert - ähnlich zu dem was du machst.

Ich denke zu kommst eher aus der Mathe/Statistik welt, ich bin eher von der anderen Seite "data science" programmiere aber eher low level mit C++.

Ja Varianz kenne ich schon - nur nenne ich das "standard deviation" oder RMSE. Wieder lustig gleiche methode aber anderes vokabular.

Das ganze echt umzusetzen ist nochmal eine challenge - ich kenne das. In real world geht so viel schief.

Moin, ja genau du hast eine sehr kleine Input Dimension und ja ich komme aus dem Bereich Statistik und Mathematik😅

Tatsächlich nutzen wir die Methode für hochdimensionale Optimierungsprobleme. Allerdings sind die Funktionen relativ glatt und viele Input Parameter können niedrig gewichtet werden.

Das Kriging ist nicht streng interpolierend, sondern lässt sich ausgezeichnet für Regression verwenden und die Varianz Vorhersage ist für solche Probleme einfach essentiell.

Du möchtest ja wissen inwiefern du der Vorhersage überhaupt trauen kannst. Besonders bei Lithium Akkus.

Wie gesagt ich finde fast jede Methode hat ihre Daseinsberechtigung, aber halt auch ihr konkretes Anwendungsgebiet. Für Klassifikation und raue Funktionen oder Bilderkennung, nlp usw. kann man solche Methoden wie kriging nicht verwenden. Da kommt man an neuronalen Netzwerken nicht vorbei.

Hi Andreas,

ich möchte demnächst wieder ein Akkupack aus 18650er Zellen zusammenbauen und schaute seit ein paar Wochen immer mal hier ins Forum ob es Neuigkeiten zu deinem KI Tool gibt.

Kannst du abschätzen wann eine erste Version zum testen zur Verfügung steht? Planst du auch eine Veröffentlichung als OpenSource Projekt z.B. auf github?

Gruß Tristan