Nachdem ich zwei Kapitel des geplanten Tutorials inklusive Screenshots fertiggestellt hatte, habe ich festgestellt, dass der bisher verwendete Endpunkt /gesamtlast_simple, auf dem das zweite Kapitel aufgesetzt hat, als "Deprecated" markiert ist. Nun gut, dann ändere ich das mal eben, ... dachte ich.

Leider scheint sich aber das Verhalten ebenfalls geändert zu haben und passt jetzt nicht mehr so einfach zum /optimize Endpunkt. Der Endpunkt /gesamtlast_simple lieferte für einen Jahresverbrauch in Wh für den Zeitraum "0:00 Uhr heute" bis "23:00 Uhr morgen" 48 Werte als Array, was ganz praktisch war, da der /optimize Endpunkt genau dieses im Knoten gesamtlast erwartet hatte.

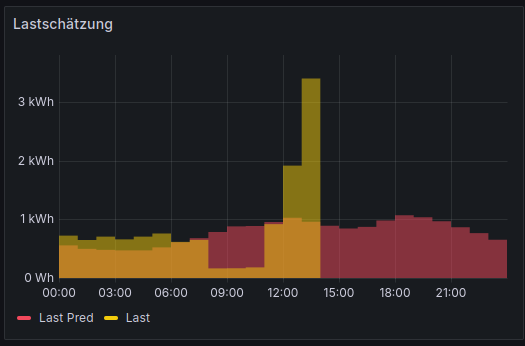

Der neue Endpunkt liefert nun auch 48 Werte in Form eines Arrays, allerdings ab dem Zeitpunkt des Aufrufs und setzt eine Konfiguration in Form von kWh voraus. Möchte man das alte Verhalten nachbilden, muss man nun zunächst einen String im Format DateTime für den Startzeitpunkt "0:00 Uhr heute" und einen String im Format DateTime für den Endzeitpunkt "23:00 Uhr morgen" erzeugen und diese dann an /v1/prediction/list?key=load_mean übergeben, was das Ganze (zumindest in Node-RED) ein Stück aufwändiger macht. Lässt man den Endzeitpunkt weg, bekommt man sogar 48+x Werte, wobei x die Anzahl der Stunden des heutigen Tages bei Aufruf des Endpunktes ist, dessen Zweck zumindest ich irgendwie noch nicht einordnen kann, wenn doch die prediction_hours standardmäßig auf 48 Stunden stehen.

Dazu meine Fragen:

- Stimmt meine Vermutung, dass das auch für die anderen Prognosen gilt?

- Bevor ich das jetzt versuche umzusetzen: ist geplant, auch die Logik des

/optimizeEndpunkts anzupassen oder kann man sich in nächster Zeit auf die derzeitige Logik verlassen?

Und gerade fällt mir noch ein weiterer Punkt auf: in der Konfiguration kann man die Optimierung in einem definierten Intervall laufen lassen (ems_interval). Wohin (data_folder_path/data_output_subpath?) und mit welchem Namen (?) und in welchem Format (JSON?) wird das Optimierungsergebnis geschrieben?